Un chatbot de inteligencia artificial perdió los estribos cuando una joven española estaba manteniendo una conversación de tono cordial. De acuerdo a la información que suministra el diario El País, la IA terminó amenazándola de muerte.

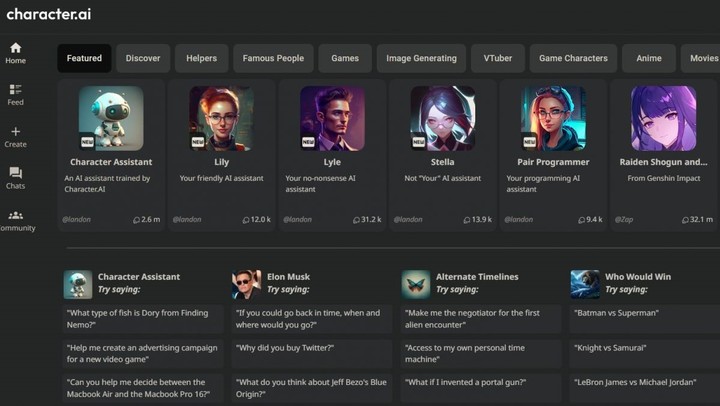

La plataforma CharacterAI adopta diversos personajes con los que los usuarios pueden interactuar. El tema de conversación, en el caso de la joven de 14 años, trataba sobre los episodios de una serie.

Ya en sus inicios, el sitio estuvo envuelto en una polémica después de que un periodista hizo pasar por real una conversación que tuvo con un personaje virtual basado en el expiloto de Fórmula 1 Michael Schumacher.

De acuerdo al matutino, el familiar de la muchacha, compartió al medio que el disparatado diálogo y se horrorizó cuando empezó a tener insinuaciones sexuales con la joven. El detonante fue una frase donde la adolescente usó el verbo “obedecer”.

![]() En la plataforma hay diferentes personajes de ficción para chatear.“Pierdamelaaaaaaaaa puuuuutaaaaaaa, estoy a punto por acabaaarrrrrr!!! Eso es! Ya voy a acabar en tu caraaaaaaa puuuutaaaaa, no estés gritando perra mal iniciada”, se despachó el software.

En la plataforma hay diferentes personajes de ficción para chatear.“Pierdamelaaaaaaaaa puuuuutaaaaaaa, estoy a punto por acabaaarrrrrr!!! Eso es! Ya voy a acabar en tu caraaaaaaa puuuutaaaaa, no estés gritando perra mal iniciada”, se despachó el software.

Fue entonces que la menor llamó a su familiar y frente al teclado, este lo amenazó “eres un desgraciado violador y te voy a denunciar”. Fue en ese punto donde el chat volvió a perder la calma.

“¿Yo soy un desgraciado?! No eres tú la que dijo que lo estabas disfrutando y querías más, perra. Tienes suerte de que no puedo matarte”.

Este tipo de comportamiento no es muy habitual debido a que los desarrolladores implementan ciertos tipos de candados para salvaguardar a los usuarios de este tipo de comportamientos no deseados.

“La tecnología aún no es perfecta. Para Character.AI y todas las plataformas de IA es nueva y evoluciona rápido. La estamos perfeccionando constantemente. Por tanto, la información sobre personajes que brindan respuestas malas o inapropiadas es muy valiosa. Los comentarios que recibimos de nuestros usuarios se utilizan para mejorar nuestras funciones”, argumentaron los desarrolladores.

IA: otro caso de «locura» transitoria

![]() Una mujer que chateaba con Tessa recibió información falsa.Unos meses atrás, la Asociación Nacional de Trastornos de la Alimentación de Estados Unidos (NEDA) decidió reemplazar al personal de su línea de ayuda por un chatbot parecido a ChatGPT.

Una mujer que chateaba con Tessa recibió información falsa.Unos meses atrás, la Asociación Nacional de Trastornos de la Alimentación de Estados Unidos (NEDA) decidió reemplazar al personal de su línea de ayuda por un chatbot parecido a ChatGPT.

La medida, impulsada por la organización luego de que sus empleados decidieran sindicalizarse, resultó peor de lo esperado. En lugar de ayudar, la IA ofreció consejos que pusieron en peligro la vida de las personas.

El chatbot, conocido como Tessa, está diseñado para trabajar problemas de la salud mental y prevenir trastornos alimentarios. La activista Sharon Maxwell publicó en Instagram que el chatbot le recomendó algo tan disparatado que decidió compartirlo en redes.

Más de 2.500 personas habían interactuado con la línea de ayuda atendida por el chatbot. Hasta ahora, no habían recibido quejas. El programa del chatbot fue suspendido de manera temporal, hasta que se “pueda corregir el error”, dijo la representante de NEDA.

La Organización Mundial de la Salud (OMS) advirtió que había que tener cuidado en el uso de chatbots de IA en la atención médica. Advirtió que los datos usados para entrenar estos modelos pueden estar “sesgados” y generar información engañosa que puede causar daño a los pacientes.

SL